想象一下,学校里有一位经验丰富的老师,他知识渊博但讲课速度较慢;而学生虽然理解能力有限,但学习速度快。老师通过简化自己的知识,用更容易理解的方式教给学生,学生最终也能掌握核心内容——这就是模型蒸馏(Model Distillation)的核心理念。

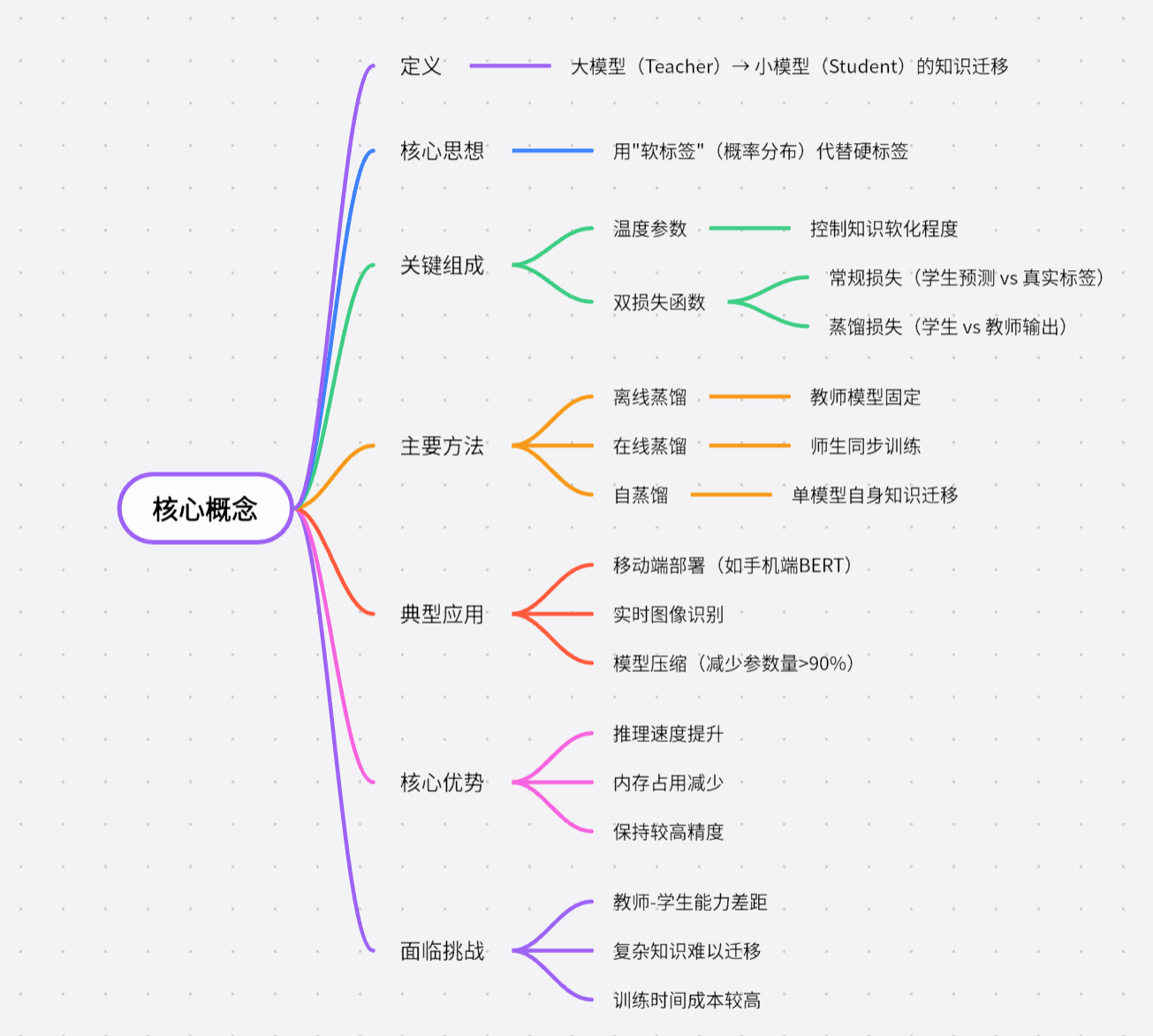

模型蒸馏是一种将大型复杂AI模型(称为“教师模型”)的知识“提炼”到小型轻量模型(称为“学生模型”)中的技术。就像老师把多年的教学经验总结成考试重点一样,教师模型将自己的预测逻辑“教”给学生模型,使得小模型既能保持高性能,又能大幅减少计算资源消耗。

模型蒸馏的原理与过程

1. 教师模型:知识库的构建

教师模型通常是参数量巨大的深度神经网络(例如GPT-3或ResNet-152),它通过海量数据训练后能做出精准预测,但运行需要高性能硬件支持。

2. 软标签 vs 硬标签:从「判断题」到「解析课」的知识传递

• 硬标签:直接给答案的「判断题」

就像考试的标准答案,硬标签只会给出唯一结论(例如“这张图是猫”)。这种方式虽然明确,但忽略了模型对其他可能性的思考,就像老师只告诉学生“选A”,却不解释为什么。

• 软标签:分析思路的「解析课」

教师模型输出的软标签是一组概率分布(例如「猫: 85%,狗: 12%,狐狸: 3%」)。这相当于老师在讲解题目时说:“虽然正确答案是A,但B选项有30%的可能性会迷惑人,因为它和A有相似特征...”

这种表达不仅包含答案,还揭示了模型对特征的深度理解(比如“猫的耳朵形状更尖,但毛发颜色接近狐狸”)。

3. 温度参数(Temperature):知识的平滑处理

在蒸馏过程中会引入温度参数T。当T>1时,概率分布会变得更平缓(例如「猫: 70%,狗: 25%,狐狸: 5%」),这就像老师把复杂的知识点拆解成更易懂的步骤。

4. 学生模型的学习阶段

学生模型(如MobileNet或TinyBERT)同时学习真实标签和教师模型的软标签,通过最小化两者的差异损失函数,逐步吸收教师模型的知识精华。

为什么软标签更好学?

假设教孩子区分苹果和西红柿:

• 硬标签教学:“红色圆形的是苹果,另一个是西红柿。”

• 软标签教学:“表面光滑的可能是苹果(70%),带斑点的更接近西红柿(25%),特别软的或许是熟过头的苹果(5%)”

后者通过细节对比,让孩子理解本质差异——这正是软标签帮助学生模型高效学习的关键!

实际应用场景

-

移动端部署

将大型图像识别模型蒸馏为能在手机上实时运行的轻量模型,例如相册自动分类功能。 -

工业实时系统

工厂质检系统中,蒸馏后的模型可在低功耗设备上快速检测产品缺陷。 -

边缘计算

智能家居设备通过蒸馏模型实现本地化语音指令识别,无需依赖云端。 -

模型安全

通过蒸馏可以去除原始模型中可能被攻击者利用的敏感信息。

未来展望

随着AI模型规模持续增大,蒸馏技术将在以下方向持续发展:

• 自动化蒸馏:自动选择最优的教师-学生模型组合

• 多教师协同:融合多个专家模型的知识

• 跨模态蒸馏:将视觉模型知识迁移到语言模型

• 联邦学习结合:在保护隐私的前提下进行分布式知识迁移

这项技术正在让“大智慧”变得“触手可及”,推动AI真正走入日常生活。

喜欢就支持一下吧!

版权声明:除却声明转载或特殊注明,否则均为艾林博客原创文章,分享是一种美德,转载请保留原链接,感谢您的支持和理解